Vol. 16 - Num. 61

Lectura crítica en pequeñas dosis

Razones para dejar de leer un artículo

aServicio de Gastroenterología. Hospital Infantil Universitario La Paz. Madrid. España.

Correspondencia: M Molina. Correo electrónico: mma1961@gmail.com

Cómo citar este artículo: Molina Arias M. Razones para dejar de leer un artículo. Rev Pediatr Aten Primaria. 2014;16:87-91.

Publicado en Internet: 14-04-2014 - Número de visitas: 19334

Resumen

Diariamente se publican gran cantidad de artículos en revistas biomédicas pero, desgraciadamente, una alta proporción de ellos está afecta de errores metodológicos que pueden poner en peligro la validez de sus resultados. Estos errores suelen deberse a la falta de formación en metodología de los autores de los artículos, que son fundamentalmente clínicos, y a la falta de revisores adecuadamente formados en las revistas científicas. Además, en algunas ocasiones los errores pueden ser deliberados para favorecer la obtención de determinadas conclusiones, como ocurre en los casos con conflicto de intereses. En el presente artículo se dan algunos consejos sobre los aspectos que podemos valorar de un trabajo científico para evitar perder nuestro valioso tiempo con trabajos que no sean de nuestro interés.

Palabras clave

● Conflicto de intereses ● MetodologíaNota:

Hay quien piensa que el lugar más idóneo para guardar el 99% de lo que se escribe en literatura médica es la papelera, incluso aunque se trate de artículos escritos por profesionales famosos en revistas de prestigio1. Esta afirmación quizá sea un poco dramática, pero de lo que no cabe duda es de que una amplia proporción de los trabajos que se publican están aquejados de errores metodológicos graves.

A pesar de que existen listas de verificación, como el caso de la CONSORT para ensayos clínicos2, para velar por la calidad metodológica de los trabajos, no todas las revistas científicas las suscriben. Por otro lado, la mayoría de los que escribimos somos clínicos con una formación metodológica más bien deficiente, por lo que no es de extrañar que nuestros trabajos contengan errores de metodología. Además, los revisores de las revistas médicas suelen ser también clínicos con el mismo grado de formación que los autores de los trabajos, con lo que pueden pasar por alto estos errores. Y, por si fuera poco, hay ocasiones en que estos errores se cometen de forma deliberada para llegar o inducir al lector a llegar a una conclusión determinada tras la lectura del trabajo.

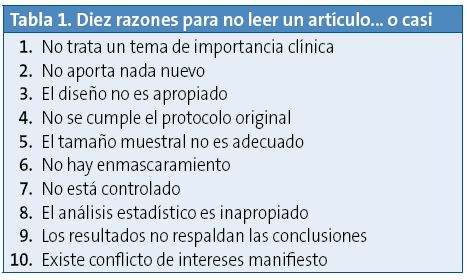

Por estos motivos, y dada la ingente cantidad de información disponible y el poco tiempo para leerla, es fundamental que sepamos detectar estas “trampas” para no perder demasiado tiempo con trabajos que deberían estar en la papelera (Tabla 1).

En ocasiones bastará con leer el resumen para detectar algunos de estos errores. Sin embargo, la mayor parte de las veces será necesaria una cuidadosa lectura del apartado de “materiales y métodos” para detectarlos.

Ofreceremos a continuación una serie de pistas para tratar de darnos cuenta de la existencia de estos errores metodológicos en relación con el contenido general y el diseño del estudio. Dejaremos para un segundo artículo la valoración de los errores e imprecisiones cometidos en el análisis estadístico de los datos del estudio.

1. ¿TRATA EL TRABAJO SOBRE UN TEMA DE INTERÉS?

Parece obvio que la primera razón para leer un trabajo es que haya alguna razón para su realización y que nos interese para nuestra práctica. De forma ideal, el título debe informar sobre los pacientes, la intervención, la comparación y las medidas de resultado tratadas en el trabajo, pero no siempre los títulos son tan descriptivos como deberían.

Puede ser útil también leer la parte inicial de trabajo, la introducción, donde debe explicarse de forma resumida el estado actual del tema y la justificación para realizar el estudio que se publica.

2. ¿SE TRATA DE UN TRABAJO ORIGINAL?

No tiene ningún sentido probar una hipótesis que ya está previamente probada, en un sentido o en otro, ni tampoco tiene sentido perder el tiempo en volver a leer algo ya leído previamente.

Sin embargo, solo un pequeño porcentaje de los artículos publicados son totalmente originales. En general, la mayoría añade o quita un poco de verosimilitud a los conocimientos previos. ¿Significa esto que debemos desecharlos? De entrada, no, pero antes de leerlos habrá que preguntarse si aportan algo nuevo que los haga merecedores de nuestra atención: la muestra es mayor, el seguimiento es más largo, la metodología es más rigurosa, etc. Además, el tema debe ser lo suficientemente importante desde el punto de vista clínico como para justificar la repetición del trabajo.

3. ¿PARA QUIÉN ES EL TRABAJO?

No debemos olvidar nunca que los participantes de un ensayo clínico no son como los pacientes de la vida real: se suelen excluir los más graves, las indicaciones de los tratamientos están restringidas, el seguimiento es más exhaustivo que el de una consulta normal y el control de los efectos adversos más riguroso. Por eso, aunque los resultados sean válidos, no debemos aplicarlos a nuestros pacientes sin considerar antes si se parecen lo suficiente a los del estudio.

Si la muestra de pacientes del estudio no es representativa de la población (existe sesgo de selección), si los criterios de inclusión son muy restrictivos o si las circunstancias del estudio son muy diferentes a las de la vida real, probablemente los resultados no nos serán de gran utilidad para nuestro trabajo. Por ejemplo, si nos dedicamos a la Atención Primaria, los resultados de un estudio con pacientes de Atención Especializada pueden no ser directamente aplicables a nuestros pacientes que, en general, tendrán una enfermedad más leve que los hospitalizados. Sin menosprecio de la calidad del trabajo publicado, que puede ser excelente, quizás sea más eficiente buscar otro tipo de trabajos.

4. ¿EL DISEÑO DEL ESTUDIO ES EL APROPIADO?

El tipo de diseño empleado depende del tipo de pregunta clínica a la que el estudio trata de responder3. Los ensayos clínicos son los más idóneos para responder a preguntas de tratamiento, mientras que los estudios de cohortes y los de casos y controles se utilizan como paso previo a la elaboración de una hipótesis causal y un ensayo clínico, o para responder a preguntas clínicas de pronóstico o de etiología/daño. Es importante comprobar que el tipo de diseño es el adecuado al tema planteado por el estudio.

Además, debe estar bien definido el tipo de intervención y con qué se compara, lo que incluye una completa descripción del tratamiento y del placebo, si se emplea. También es fundamental que se describa claramente la variable principal de resultado y cómo se ha medido.

Esta variable de resultado tiene que ser importante desde el punto de vista clínico y para el paciente, debe ser objetiva y debe ser tal que cambios en ella reflejen cambios reales en el paciente. El uso de variables poco importantes para el paciente o de variables subrogadas de escaso impacto clínico puede hacernos perder interés por acabar de leer el trabajo.

Para terminar con la valoración del diseño del estudio, debemos comprobar que los autores cumplen el protocolo definido previamente al inicio del ensayo. Cualquier violación o cambio de protocolo debe estar justificada. El cambio de las condiciones del ensayo, por dificultades encontradas durante la realización o por interés de los autores, debe hacernos desconfiar de los resultados. Parece razonable interrumpir un ensayo si se detectan efectos adversos graves para los participantes, pero es más difícil justificar la interrupción precoz por encontrar los resultados buscados por los autores. El seguimiento debe ser siempre completo, y se ha de dar cuenta de las pérdidas de los participantes que se produzcan durante el mismo.

Además, el análisis de los resultados debe hacerse conforme al protocolo inicial. Debemos dudar siempre de las conclusiones de análisis parciales post hoc no especificados previamente antes de iniciar el ensayo. No es correcto “torturar los resultados del estudio hasta que confiesen”.

5. ¿SE HA INTENTADO EVITAR LOS ERRORES SISTEMÁTICOS?

Este punto forma parte de la valoración de la validez interna del trabajo cuando hacemos lectura crítica, pero daremos unas pistas esenciales para detectar errores metodológicos que pueden invalidar los resultados.

En el caso de los ensayos clínicos, pueden detectarse fácilmente el riesgo de sesgos de selección y de información. Los dos grupos de comparación tienen que ser similares en todo excepto en la intervención en estudio. Los ensayos deben tener una tabla con las características de las dos muestras para asegurar su comparabilidad.

Si el ensayo es aleatorizado, cualquier diferencia entre las dos poblaciones iniciales será aleatoria, con independencia de que sea estadísticamente significativa o no, por lo que no tiene mucho sentido calcular el valor de la p, más teniendo en cuenta que el tamaño muestral no está calculado para hacer este contraste de hipótesis, sino para valorar el efecto de la intervención. En cualquier caso, si existe alguna diferencia basal entre los dos grupos, debemos comprobar que los autores valoran su importancia clínica y realizan el ajuste adecuado a la hora del análisis de resultados.

Además de ser comparables, ambos grupos deben ser tratados de forma similar durante todo el seguimiento. Si hay diferencias existirá riesgo de sesgos de información, que restan validez interna al trabajo.

Si se trata de un estudio de cohortes, observaremos si la selección de las dos cohortes se ha hecho de forma adecuada y cómo se ha medido el efecto de forma similar en ambas cohortes. Por último, en los estudios de casos y controles resulta fundamental observar la definición de caso y de control para valorar la posible existencia de sesgos de mala clasificación.

6. ¿EL TAMAÑO MUESTRAL ES APROPIADO?

El cálculo del tamaño de la muestra tiene que ser realizado antes del comienzo del estudio. Los autores deben definir el efecto clínicamente importante que quieren ser capaces de detectar y calcular a continuación qué tamaño muestral confiere al estudio la potencia suficiente para demostrarlo.

El tamaño de la muestra condiciona de forma importante la probabilidad de detectar el efecto de la intervención. Si la muestra es pequeña puede no detectarse un efecto existente, mientras que si la muestra es grande puede conseguirse significación estadística, con diferencias de efecto que son poco importantes desde el punto de vista clínico.

7. ¿SE HIZO UNA VALORACIÓN CIEGA DEL EFECTO?

El uso riguroso de un grupo control comparable con el de intervención será una pérdida de tiempo si no realizamos el enmascaramiento de forma adecuada. Es muy raro que dos médicos, aun competentes, lleguen a un acuerdo completo al valorar datos de una exploración física o de ciertas pruebas diagnósticas.

Además, la atención durante el seguimiento puede verse condicionada por la presencia o ausencia de enmascaramiento. Si sabemos que un paciente ha sido asignado al grupo del placebo, probablemente seremos menos diligentes en la valoración de los efectos adversos del tratamiento y, en general, en la atención que le prestamos durante el seguimiento, con el consiguiente riesgo de sesgo que pone en peligro la validez del estudio.

En ocasiones, dada la naturaleza del estudio, puede ser imposible realizar el enmascaramiento del paciente (ciego simple) o del paciente y el investigador (doble ciego). En estos casos lo ideal es recurrir a un evaluador ciego que examine los resultados de la investigación sin saber a qué grupo pertenecen.

8. ¿ES EL ESTUDIO ESTADÍSTICO INCORRECTO O INAPROPIADO?

Quizá sea en este apartado donde más dificultades encontremos la mayor parte de los lectores a la hora de valorar la validez de un artículo científico.

Aunque dedicaremos otro artículo a describir algunas de las posibles “trampas” que podemos encontrarnos en el análisis estadístico, nos referiremos ahora a tres aspectos del estudio estadístico que deben tenerse en cuenta antes de comenzar el estudio, y que ya hemos comentado parcialmente: el tamaño muestral, la duración del seguimiento y que el seguimiento sea completo.

Como ya hemos dicho, el tamaño de la muestra debe calcularse antes de comenzar el estudio. Insistimos en que la muestra debe ser lo suficientemente grande como para detectar un efecto clínicamente importante (previamente definido por los autores) y no debe supeditarse únicamente a la consecución de una diferencia estadísticamente significativa.

Con el tamaño muestral correcto, la duración del seguimiento debe ser suficiente como para que el efecto de la intervención se manifieste en la variable de resultado. Como ya hemos mencionado, el seguimiento debe ser completo siempre: aunque detectemos diferencias significativas antes del plazo previsto de finalización, estas pueden no mantenerse hasta la finalización del estudio.

Es inevitable que cierto número de participantes abandone el estudio durante el seguimiento, ya sea de forma voluntaria (abandonos propiamente dichos) o involuntaria (pérdidas durante el seguimiento). Estas pérdidas o abandonos deben tenerse en cuenta a la hora del análisis estadístico de los resultados ya que, de lo contrario, su validez se verá comprometida.

9. ¿SE DERIVAN LAS CONCLUSIONES DE LOS RESULTADOS?

Esta pregunta puede parecer obvia, pero nada más lejos de la realidad. Aunque los autores deben plantear su hipótesis de trabajo antes de iniciarlo y el trabajo debe hacerse de manera imparcial, hay ocasiones en las que el interés de los autores por demostrar la hipótesis en uno u otro sentido puede hacerles interpretar los resultados de forma poco objetiva.

Esto puede favorecerse por el uso de medidas de frecuencia o impacto inadecuadas, “más vistosas”, como puede ser el uso de la reducción relativa del riesgo en lugar de la reducción absoluta o el número necesario a tratar4, o la elección de algún método estadístico oscuro y rebuscado que parezca demostrar lo que los autores del estudio persiguen desde un principio.

10. ¿EXISTE CONFLICTO DE INTERESES?

Está claro que el conflicto de intereses puede tener una gran influencia sobre los ensayos que se realizan, sobre cómo se realizan y sobre cómo se interpretan sus resultados para llegar a las conclusiones apetecidas, siendo muy variadas las políticas de las revistas biomédicas en relación con este aspecto5.

El conflicto de intereses debe ser siempre declarado por parte de los investigadores y tenido en cuenta a la hora de valorar las conclusiones del estudio por parte de los lectores.

CONFLICTO DE INTERESES

El autor declara no presentar conflictos de intereses en relación con la preparación y publicación de este artículo.

BIBLIOGRAFÍA

- Altman DG. Poor-quality medical research: what can journal do? JAMA. 2002;287:2765-7.

- González de Dios J, Buñuel Álvarez JC, González Rodríguez P. Listas guía de comprobación de ensayos clínicos: declaración CONSORT. Evid Pediatr. 2011;7:72.

- Buñuel Álvarez JC, Ruiz-Canela Cáceres J. Cómo elaborar una pregunta clínica. Evid Pediatr. 2005;1:10.

- Molina Arias M. Cálculo de la reducción del riesgo y el número necesario de pacientes a tratar. Rev Pediatr Aten Primaria. 2012;4:369-72.

- Blum JA, Freeman K, Dart RC, Cooper RJ. Requirements and definitions in conflict of interest policies of medical journals. JAMA. 2009;302:2230-4.